D i era digital saat ini, interaksi dengan Large Language Model (LLM) atau yang sering kita sebut AI sudah menjadi bagian tak terpisahkan dari kehidupan sehari-hari. Mulai dari ChatGPT, Claude, hingga Gemini, model-model ini telah berevolusi dari chatbot yang sering berhalusinasi menjadi alat yang sangat berguna. Namun, sebagian besar interaksi ini terjadi melalui layanan cloud yang dikelola oleh perusahaan besar, menimbulkan pertanyaan penting seputar privasi data dan kendali pengguna. Pertanyaannya, bisakah kita memiliki kekuatan AI ini di tangan kita sendiri, di komputer lokal kita, tanpa perlu khawatir tentang data yang keluar? Jawabannya adalah ya, dan artikel ini akan memandu Anda secara mendalam.

Memilih untuk menjalankan LLM secara lokal bukan hanya tentang privasi, tetapi juga tentang kebebasan, kontrol penuh atas data Anda, potensi kecepatan inferensi yang lebih tinggi, dan bahkan efisiensi biaya dalam jangka panjang. Meskipun model lokal secara historis tertinggal dari model frontier dalam beberapa aspek, rilis model open-weight yang semakin canggih dari pemain seperti OpenAI dan Qwen menunjukkan bahwa LLM lokal kini sangat mumpuni untuk berbagai tugas sehari-hari. Artikel ini hadir sebagai panduan komprehensif yang dirancang agar mudah diakses oleh siapa saja, menjelaskan mengapa Anda harus mempertimbangkan opsi ini, persyaratan yang dibutuhkan, serta opsi dan alat terbaik untuk memulai petualangan Anda dengan AI lokal. Mari kita selami dunia LLM lokal dan temukan kemandirian dalam kekuatan AI.

Mengapa Menjalankan LLM Lokal? Privasi, Kontrol, dan Keunggulan Lainnya

Keputusan untuk menjalankan LLM lokal seringkali didorong oleh keinginan akan privasi dan kontrol, tetapi manfaatnya jauh melampaui itu. Di tengah kekhawatiran yang meningkat tentang bagaimana data pribadi kita diproses dan disimpan oleh penyedia layanan cloud, memiliki model AI di perangkat Anda sendiri menawarkan ketenangan pikiran yang tak ternilai. Ini berarti percakapan atau data sensitif yang Anda masukkan ke dalam model tidak akan pernah meninggalkan lingkungan komputer Anda, memberikan lapisan keamanan dan kerahasiaan yang tidak bisa ditawarkan oleh layanan berbasis cloud. Selain privasi, ada beberapa keunggulan signifikan lainnya yang membuat opsi ini sangat menarik.

- Privasi Data Mutlak: Ini adalah alasan utama banyak orang beralih ke LLM lokal. Data sensitif Anda, baik itu informasi pribadi, catatan pekerjaan, atau ide-ide rahasia, tetap berada di perangkat Anda dan tidak dikirim ke server pihak ketiga mana pun. Ini adalah fondasi keamanan data yang kokoh.

- Beroperasi Sepenuhnya Offline: Setelah model diunduh, Anda dapat menggunakannya tanpa koneksi internet. Ini sangat berguna untuk lingkungan kerja dengan keamanan tinggi atau ketika Anda berada di lokasi tanpa akses jaringan yang stabil. Fleksibilitas ini juga membebaskan Anda dari ketergantungan pada stabilitas server atau bandwidth internet.

- Bebas Biaya Operasional (Hampir): Setelah investasi awal pada hardware (jika diperlukan), biaya penggunaan LLM lokal nyaris nol. Anda hanya akan mengeluarkan biaya listrik yang tidak signifikan untuk daya inferensi, tanpa biaya langganan bulanan atau biaya per penggunaan token seperti pada model cloud.

- Potensi Kecepatan Inferensi Lebih Cepat: Terkadang, model lokal dapat menghasilkan output (token) lebih cepat dibandingkan model frontier yang mungkin mengalami masalah beban server pada jam sibuk. Kecepatan ini sangat bergantung pada spesifikasi hardware Anda, terutama GPU.

- Integrasi API Lokal dengan Alat Favorit: Banyak alat LLM lokal menyediakan antarmuka API yang kompatibel dengan standar OpenAI. Ini memungkinkan Anda mengintegrasikan LLM pribadi Anda ke dalam aplikasi favorit seperti VSCode, Obsidian, atau script kustom, membuka pintu untuk alur kerja yang sangat personal dan efisien.

- Kemampuan Host untuk Jaringan Lokal: Anda dapat mengonfigurasi LLM lokal Anda untuk diakses oleh perangkat lain di jaringan rumah atau kantor Anda. Ini bisa menjadi solusi AI internal yang hemat biaya untuk tim kecil atau keluarga.

- Potensi Fine-Tuning untuk Tujuan Spesifik: Bagi para pengembang dan peneliti, LLM lokal menawarkan kemampuan untuk fine-tuning model dengan kumpulan data spesifik Anda. Ini menciptakan model yang sangat dioptimalkan untuk tugas-tugas niche, seperti menulis kode dalam bahasa pemrograman tertentu, membuat konten berdasarkan gaya penulisan unik Anda, atau memproses data industri tertentu.

- Aksesibilitas untuk Semua: Dengan kemajuan dalam teknik kuantisasi, LLM kini dapat berjalan pada hardware konsumen yang lebih terjangkau, membuat AI canggih dapat diakses oleh khalayak yang lebih luas.

Memahami keunggulan ini adalah langkah pertama untuk mengeksplorasi bagaimana menjalankan LLM lokal dapat merevolusi cara Anda berinteraksi dengan kecerdasan buatan.

Persyaratan Sistem untuk Menjalankan LLM Lokal: Memahami Hardware Anda

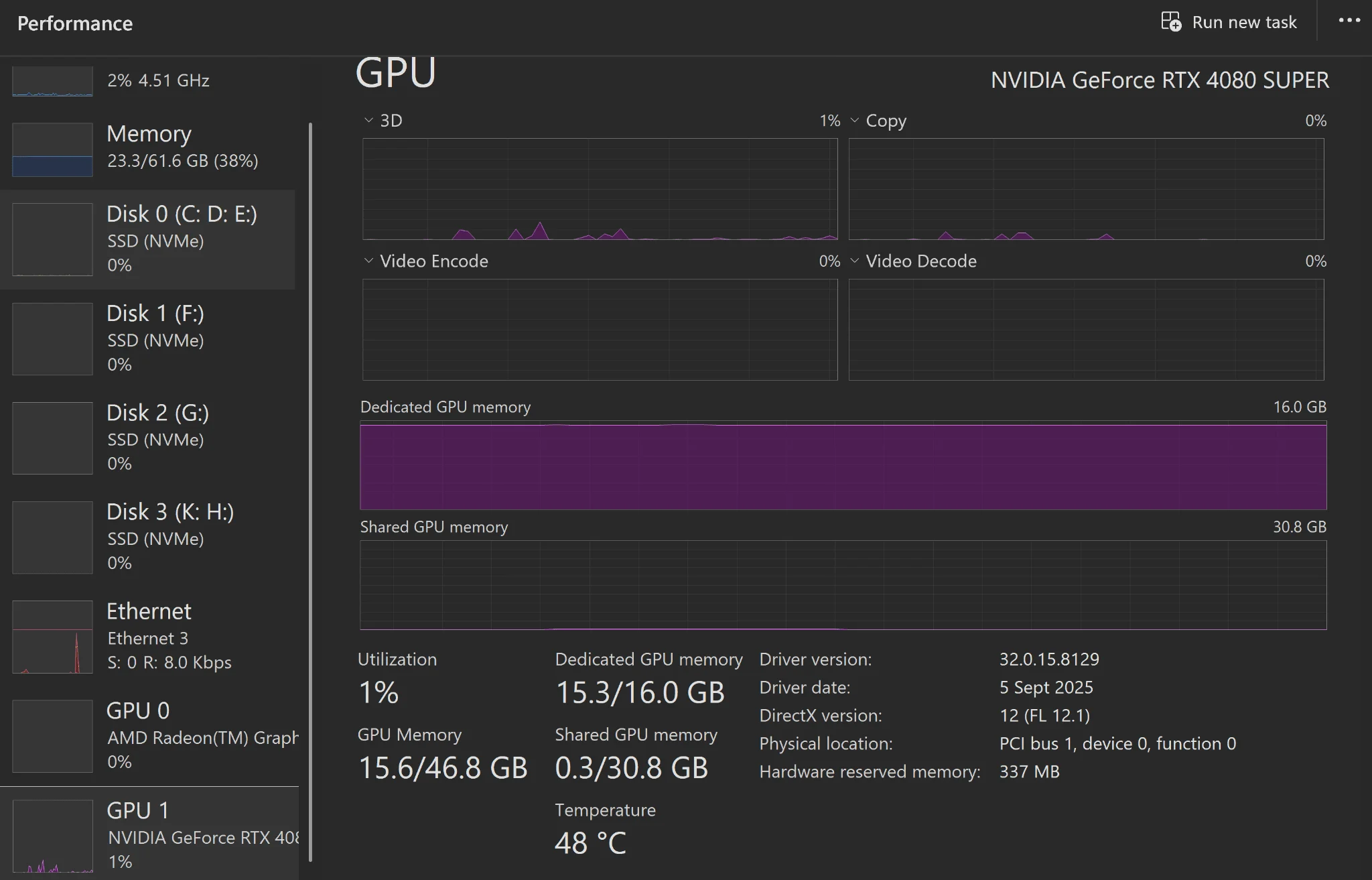

Meskipun gagasan untuk menjalankan LLM lokal terdengar menarik, penting untuk memahami persyaratan hardware yang mendasarinya. Sama seperti aplikasi atau game berat lainnya, performa LLM akan sangat bergantung pada kapasitas sistem Anda. Aturan praktis yang paling penting adalah bahwa ukuran model (dalam gigabyte) yang ingin Anda jalankan harus lebih kecil dari kapasitas RAM Anda, dengan sisa yang cukup untuk sistem operasi dan aplikasi lain agar tidak menyebabkan sistem crash atau hang. Namun, ada beberapa aspek hardware spesifik yang perlu diperhatikan.

Memori Akses Acak (RAM): Fondasi untuk Model LLM

RAM adalah komponen paling krusial. Model LLM, terutama yang lebih besar, membutuhkan sejumlah besar RAM untuk memuat parameter mereka. Misalnya, model 7 miliar parameter (7b) yang dikuantisasi 4-bit mungkin membutuhkan sekitar 4-5 GB RAM, sementara model 20b yang dikuantisasi serupa bisa memerlukan 14-15 GB. Jika RAM Anda tidak mencukupi, sistem akan mencoba menggunakan swap space di drive penyimpanan, yang akan memperlambat inferensi secara drastis. Selalu pilih model yang ukurannya jauh di bawah total RAM Anda, idealnya menyisakan setidaknya 8-16 GB untuk sistem.

Unit Pemrosesan Grafis (GPU): Akselerasi Inferensi yang Tak Tergantikan

Meskipun tidak selalu menjadi persyaratan mutlak (banyak model bisa berjalan di CPU), memiliki GPU sangat disarankan untuk mendapatkan kecepatan generasi token (output teks) yang cepat dan memuaskan. GPU modern dirancang untuk komputasi paralel, yang sangat cocok untuk operasi matriks yang intensif dalam inferensi LLM. Pengguna Mac dengan chipset M-series (M1, M2, M3) akan mendapatkan manfaat besar dari Neural Engine yang terintegrasi, yang sangat efisien untuk tugas AI. Sementara itu, pengguna PC dengan GPU dedicated dari Nvidia, terutama seri RTX, akan merasakan performa terbaik berkat arsitektur CUDA mereka yang dioptimalkan untuk pembelajaran mesin.

- VRAM GPU: Sama pentingnya dengan RAM sistem, VRAM pada GPU Anda menentukan seberapa banyak model dapat “offload” ke GPU. Semakin banyak VRAM, semakin cepat dan efisien proses inferensi. Model yang sepenuhnya muat di VRAM akan jauh lebih cepat.

- CPU: Meskipun GPU mengambil sebagian besar beban kerja inferensi, CPU yang modern dan cepat tetap penting untuk pemrosesan prompt awal dan koordinasi data antara CPU dan GPU.

- Penyimpanan: Pastikan Anda memiliki ruang penyimpanan yang cukup untuk model-model yang diunduh (beberapa model bisa berukuran puluhan GB) dan SSD (Solid State Drive) sangat dianjurkan untuk kecepatan pemuatan yang lebih baik.

Memilih hardware yang tepat adalah kunci untuk mendapatkan pengalaman terbaik saat menjalankan LLM lokal. Jangan ragu untuk memulai dengan spesifikasi yang Anda miliki, lalu tingkatkan jika kebutuhan dan anggaran memungkinkan.

Konsep Kunci di Balik LLM Lokal: Quantisasi dan Llama.cpp

Bagi banyak orang yang baru mengenal dunia menjalankan LLM lokal, ada beberapa konsep teknis yang penting untuk dipahami agar dapat mengoptimalkan pengalaman mereka. Anda tidak perlu menjadi ahli ilmu komputer, tetapi mengetahui dasar-dasar ini akan sangat membantu dalam memilih model dan alat yang tepat. Dua pilar utama yang memungkinkan LLM canggih berjalan di hardware konsumen adalah llama.cpp dan teknik kuantisasi.

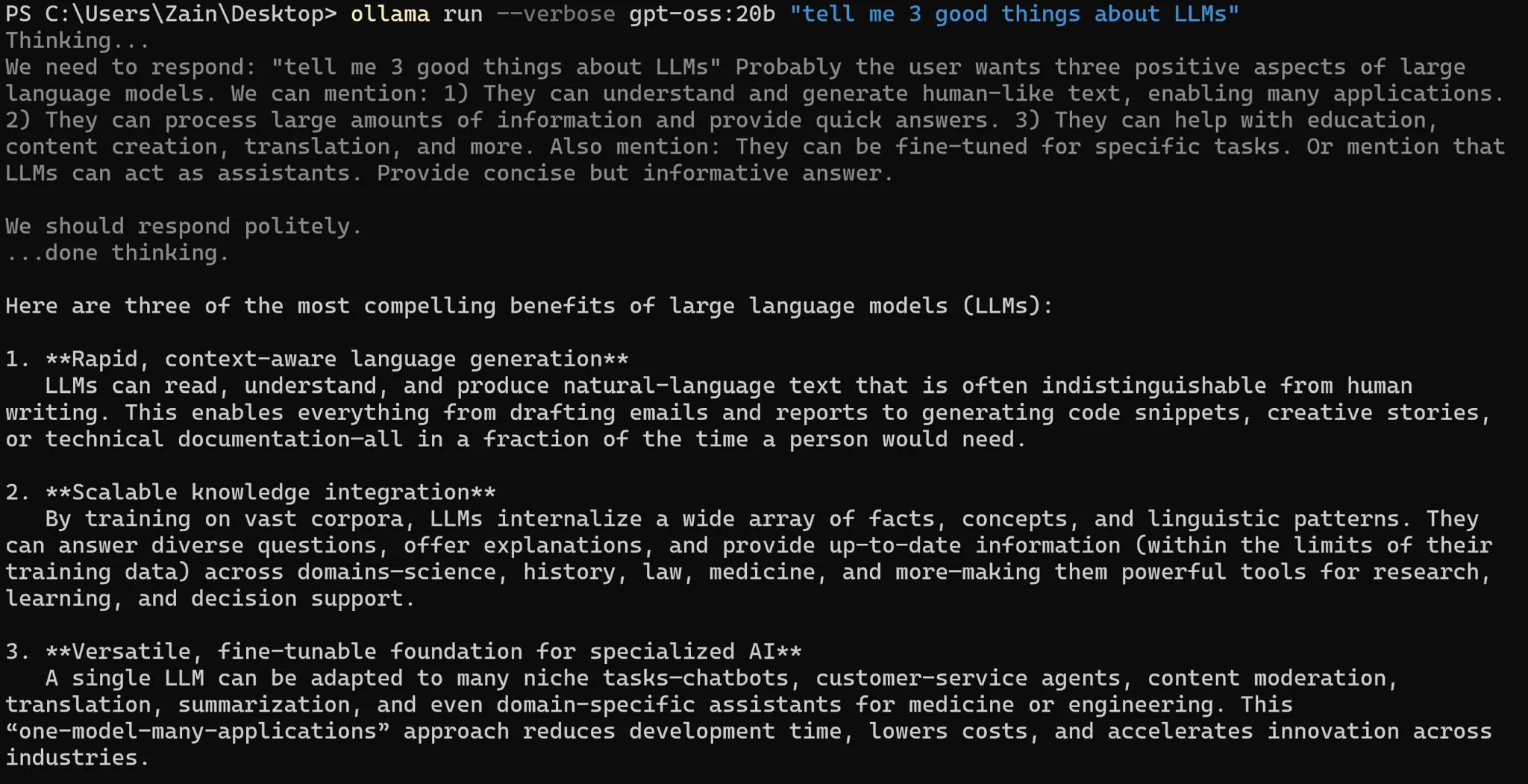

Llama.cpp: Jantung Inferensi LLM Lokal

Proyek llama.cpp adalah tulang punggung dari sebagian besar alat LLM lokal yang populer saat ini. Ini adalah proyek sumber terbuka yang revolusioner oleh Georgi Gerganov, dirancang untuk inferensi LLM yang sangat efisien pada CPU, dan kemudian diperluas untuk mendukung GPU. Filosofi desainnya adalah efisiensi ekstrem, menggunakan integer quantization dan teknik optimasi lainnya untuk menjalankan model LLM besar dengan memori dan daya komputasi yang jauh lebih sedikit dibandingkan metode tradisional. Kebanyakan antarmuka pengguna grafis (GUI) untuk LLM lokal adalah “wrapper” dari llama.cpp, yang berarti mereka mengurus konfigurasi awal dan interaksi tingkat rendah dengan model, sehingga pengguna dapat langsung fokus pada penggunaan AI.

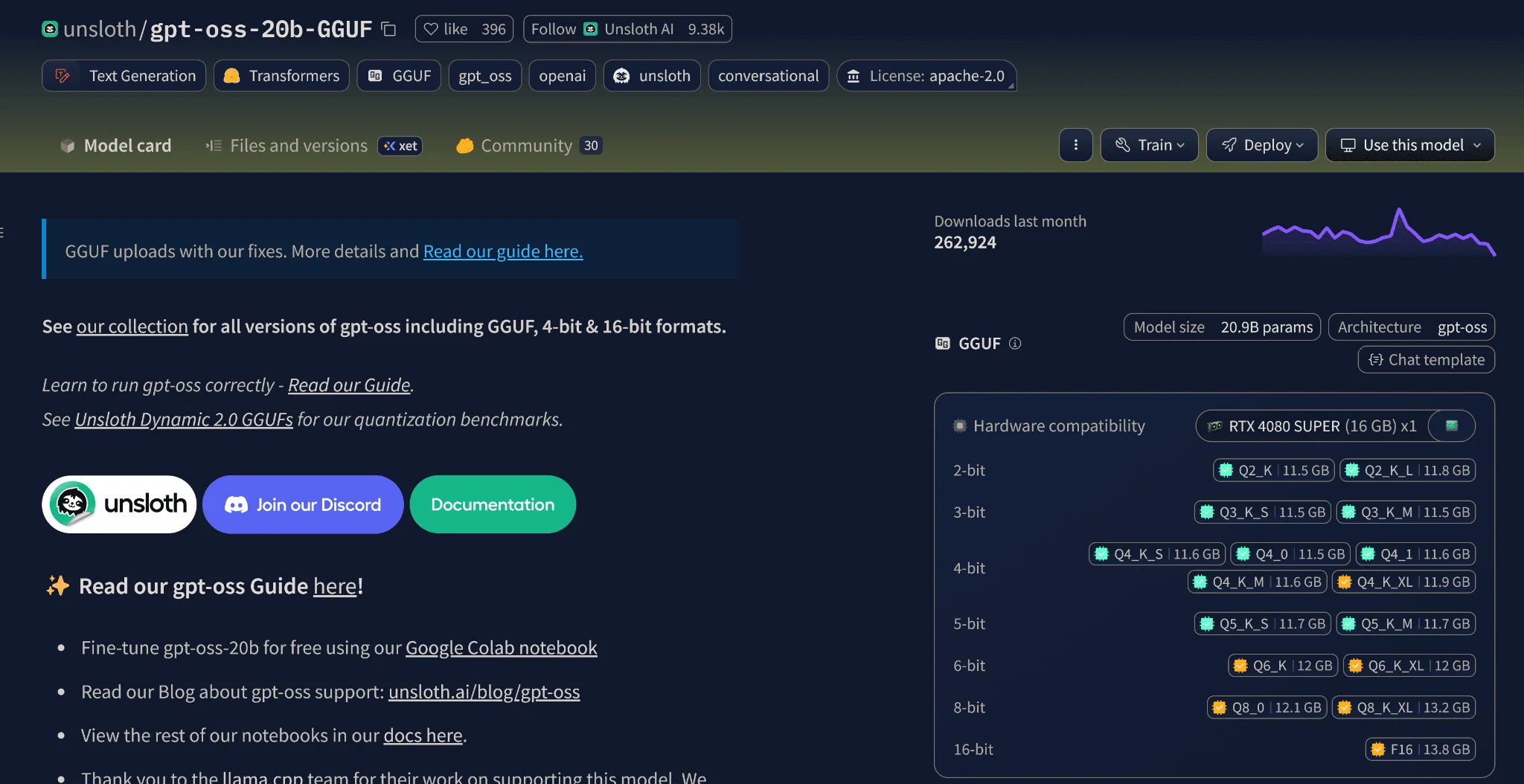

Kuantisasi: Menjadikan LLM Lebih Ringan dan Cepat

Salah satu alasan mengapa LLM dapat berjalan di mesin konsumen adalah melalui proses yang disebut “kuantisasi”. Secara sederhana, kuantisasi adalah teknik untuk mengurangi presisi numerik (jumlah bit) yang digunakan untuk merepresentasikan parameter (berat) model. Model LLM asli, seperti GPT-oss-20b, mungkin membutuhkan presisi floating-point 16-bit atau bahkan 32-bit, yang memerlukan VRAM GPU atau RAM sistem sebesar 40-80 GB. Ini jelas tidak praktis untuk komputer konsumen. Melalui kuantisasi, presisi ini dikurangi menjadi 8-bit, 4-bit, atau bahkan 2-bit integer. Contohnya:

- Model asli gpt-oss-20b mungkin memerlukan 48 GB RAM.

- Versi kuantisasi 4-bit dari model yang sama mungkin hanya membutuhkan sekitar 14.27 GB RAM, dengan performa yang mirip.

Kuantisasi membuat LLM dapat diakses oleh semua orang, bahkan jika Anda tidak memiliki GPU khusus. Model presisi 4-bit (misalnya, Q4_K_M) sering dianggap sebagai titik optimal, menawarkan keseimbangan yang baik antara kualitas, kecepatan, dan ukuran file. Sebagian besar alat akan mengkonfigurasi ini secara default. Penting untuk diingat bahwa “b” dalam nama model seperti “7b” atau “20b” mengacu pada miliaran parameter yang digunakan untuk melatih model tersebut. Secara umum, model dengan parameter lebih banyak cenderung lebih kapabel. Sebagai contoh, model 7b 4-bit yang dikuantisasi biasanya akan berkinerja lebih baik daripada model 3b 8-bit yang dikuantisasi. Memahami konsep ini akan membantu Anda membuat keputusan yang lebih cerdas saat memilih model yang akan Anda gunakan untuk kebutuhan Anda.

Ollama: Solusi Sederhana untuk Memulai LLM Lokal

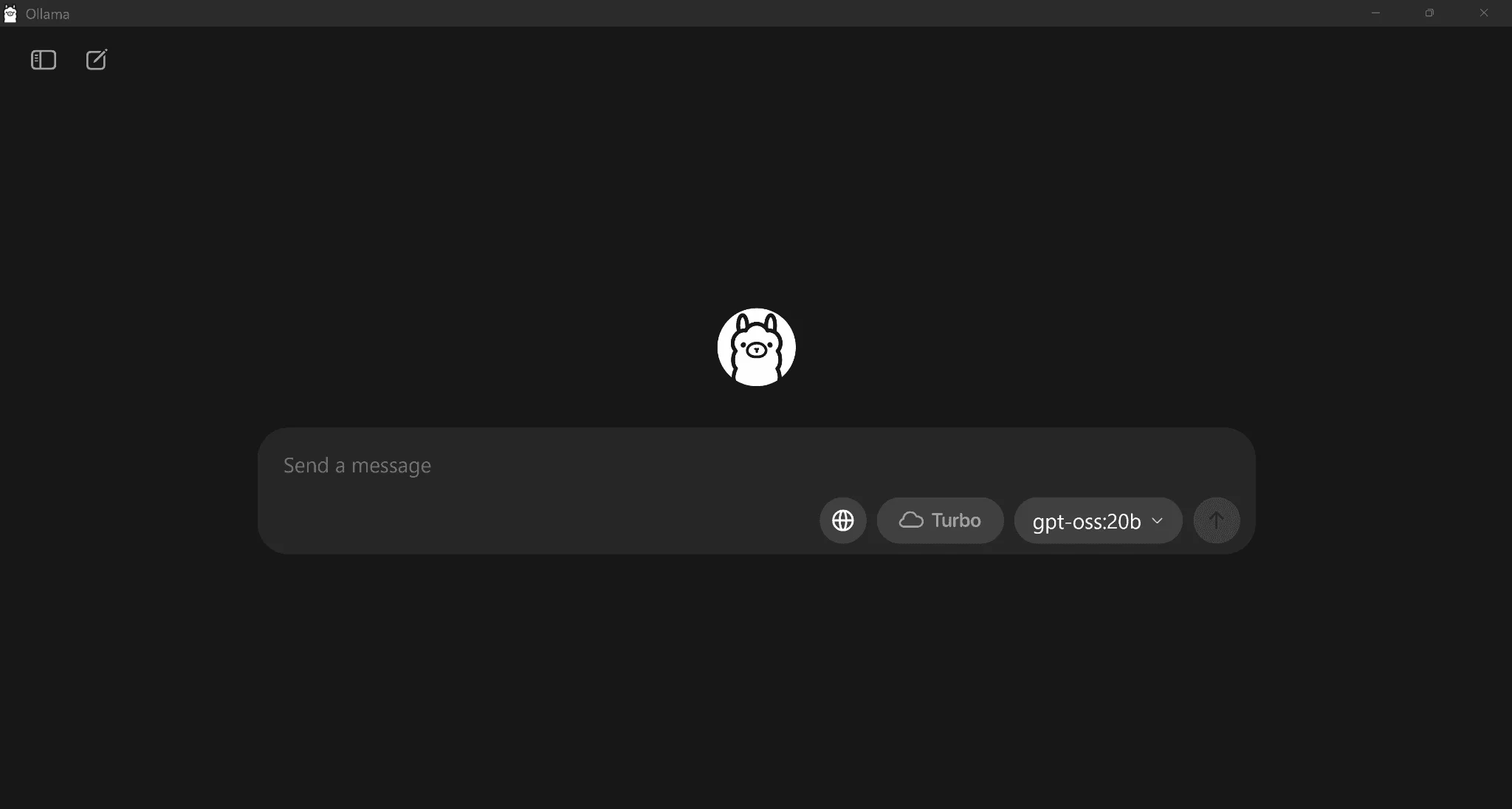

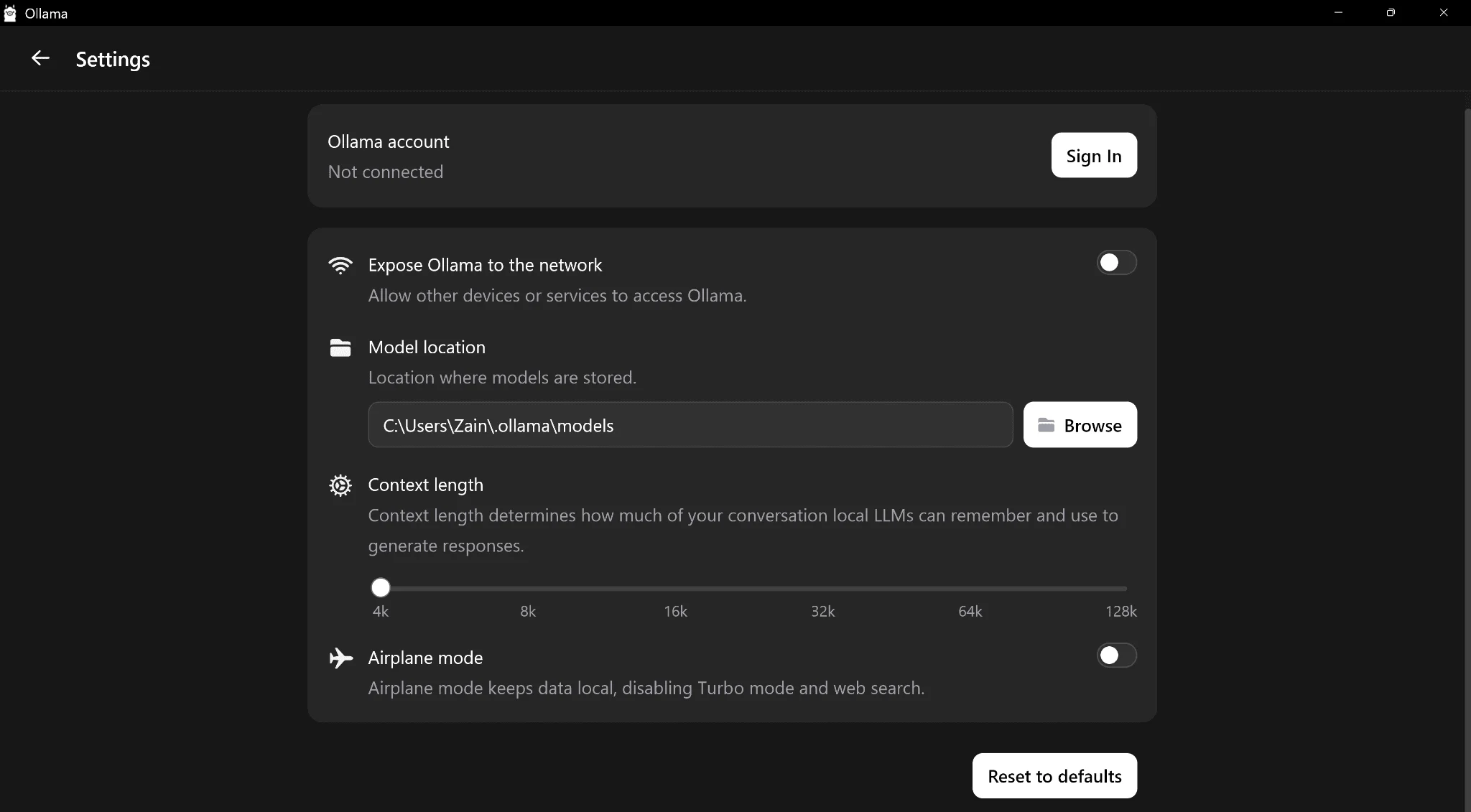

Bagi banyak orang, Ollama adalah pintu gerbang termudah untuk mulai menjalankan LLM lokal di perangkat mereka. Sebagai proyek sumber terbuka, Ollama menawarkan pengalaman yang sangat sederhana dan bersih, mengingatkan pada antarmuka ChatGPT yang familiar. Kemudahan penggunaannya membuatnya menjadi pilihan ideal bagi pemula yang ingin segera merasakan manfaat AI lokal tanpa harus terlibat dalam konfigurasi teknis yang rumit.

Proses instalasi Ollama sangatlah mudah: Anda cukup mengunduh dan menginstalnya, lalu memilih model dari daftar drop-down. Setelah model selesai diunduh, ia akan secara otomatis memuat dirinya sendiri, menangani semua konfigurasi di latar belakang. Dalam hitungan menit, Anda sudah siap untuk mulai berinteraksi dengan LLM yang di-host secara lokal dengan privasi penuh. Fitur ini sangat berharga jika Anda sering merasa lelah menyunting informasi pribadi ketika berinteraksi dengan model frontier dari penyedia besar.

Kelebihan dan Keterbatasan Ollama

Kekuatan utama Ollama terletak pada kesederhanaannya. Ini adalah berkah sekaligus kutukan. Antarmuka yang intuitif memungkinkan siapa saja untuk segera menggunakannya, tetapi di sisi lain, Ollama memiliki ruang konfigurasi yang sangat terbatas jika Anda menggunakan antarmuka grafisnya. Untuk penyesuaian yang lebih mendalam, Anda perlu beralih ke antarmuka Command Line Interface (CLI), yang mungkin kurang menarik bagi pengguna yang mencari solusi “klik dan jalankan”.

Salah satu aspek yang terkadang membuat frustrasi adalah ketidakmampuan untuk memilih model mana yang muncul di daftar drop-down. Ini bisa menjadi masalah kecil jika Anda ingin menjaga daftar model tetap rapi. Dari pengalaman beberapa pengguna, kecepatan generasi token di Ollama kadang-kadang bisa terasa lebih lambat dibandingkan dengan alat lain, meskipun ini mungkin disebabkan oleh konfigurasi sistem individu daripada masalah inherent pada platform. Namun, bagi sebagian besar pengguna, Ollama menawarkan kinerja yang memadai.

Meskipun demikian, sebagai platform sumber terbuka, Ollama memiliki komunitas yang aktif dan terus berkembang. Anda bahkan dapat membangunnya sendiri melalui Docker, memberikan tingkat fleksibilitas bagi mereka yang memiliki keahlian teknis. Jika Anda mencari cara yang mudah, cepat, dan privat untuk memulai dengan LLM lokal, Ollama adalah pilihan yang sangat direkomendasikan.

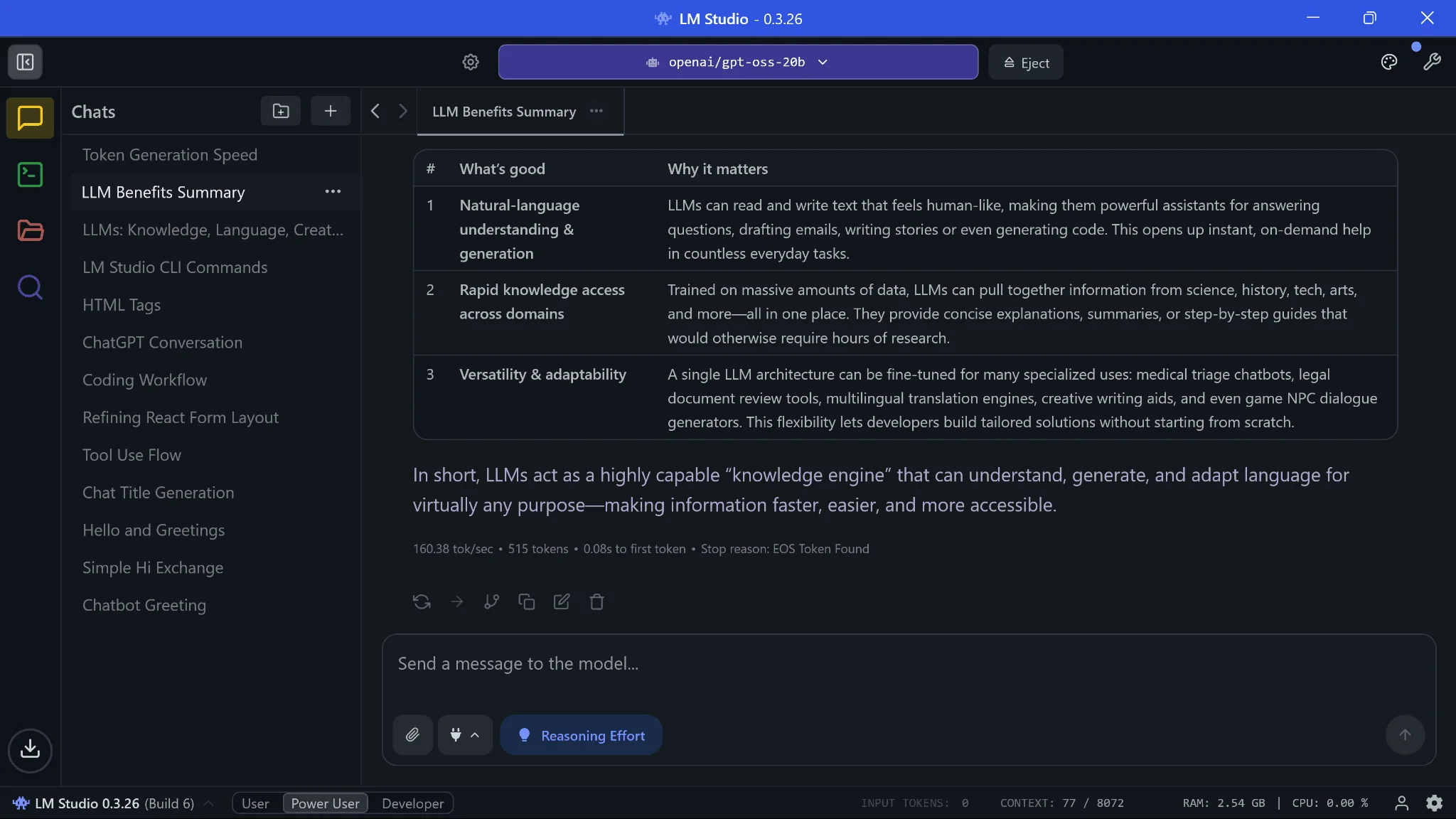

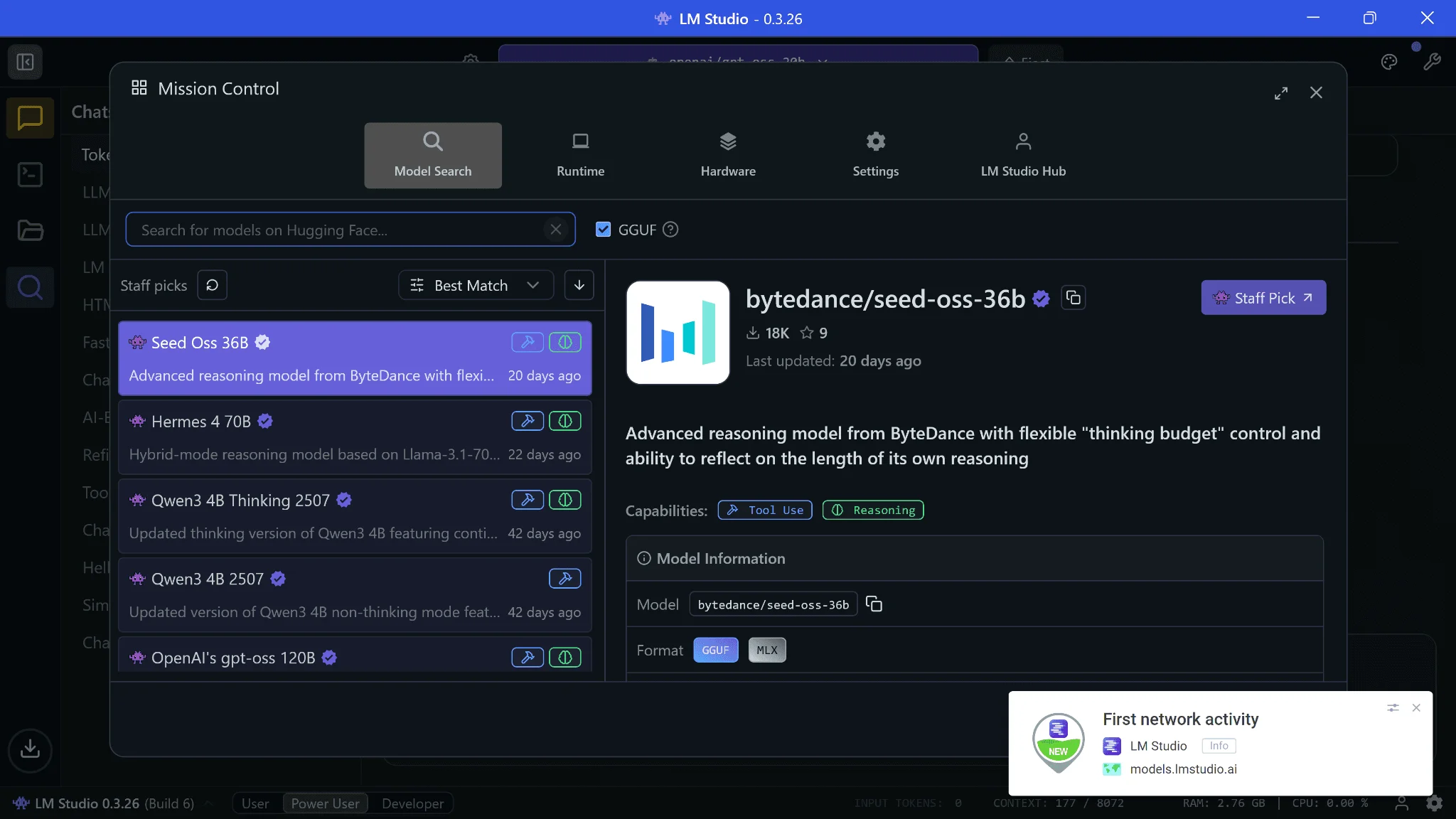

LM Studio: Antarmuka Kaya Fitur untuk Pengalaman Lebih Baik

Bagi mereka yang menginginkan kontrol lebih besar dan antarmuka yang lebih kaya fitur saat menjalankan LLM lokal, LM Studio sering dianggap sebagai pilihan yang superior dibandingkan Ollama. LM Studio menawarkan pengalaman desktop yang lebih komprehensif dengan berbagai fitur Quality of Life (QOL) yang dirancang untuk meningkatkan interaksi Anda dengan LLM. Sama seperti Ollama, proses penyiapan LM Studio sangat mudah: cukup instal aplikasi, pilih model yang ingin Anda unduh dari perpustakaan yang luas, dan Anda siap menggunakannya.

Salah satu hal yang paling menonjol dari LM Studio adalah kecepatan generasi tokennya yang seringkali luar biasa. Banyak pengguna melaporkan kecepatan yang jauh lebih tinggi dibandingkan dengan layanan cloud populer sekalipun. Kecepatan ini adalah kejutan yang menyenangkan, terutama jika Anda sering mengalami keterlambatan dari model frontier pada jam-jam sibuk. Tentu saja, performa ini sangat bergantung pada hardware Anda, dengan GPU yang kuat memberikan keuntungan signifikan.

Manajemen Sumber Daya dan Pertimbangan Privasi

Keunggulan lain dari self-hosting LLM adalah efisiensi penggunaan sumber daya. Model tidak akan menggunakan komputasi yang signifikan kecuali Anda benar-benar menggunakannya. Meskipun mereka dimuat ke memori, penggunaan GPU biasanya minimal kecuali saat inferensi aktif. LM Studio bahkan memungkinkan Anda untuk mengonfigurasi model agar “dikeluarkan” dari memori jika tidak digunakan selama periode tertentu, mencegah aplikasi lain yang sangat bergantung pada GPU (seperti pengeditan video atau rendering 3D) mengalami crash.

Namun, ada satu hal yang mungkin menjadi pertimbangan: LM Studio adalah perangkat lunak sumber tertutup (closed-source). Ini mungkin terdengar kontradiktif dengan tujuan privasi LLM lokal. Namun, pengembang LM Studio sangat transparan. Menurut kebijakan privasi mereka (lmstudio.ai/app-privacy), mereka hanya mengumpulkan spesifikasi sistem Anda untuk memberikan pembaruan runtime yang akurat dan aktivitas “anonim” untuk pencarian model. Tidak ada aktivitas jaringan dari LM Studio selama sesi chat, kecuali Anda membuka fitur pencarian model. Anda juga selalu dapat menonaktifkan akses internet untuk LM Studio melalui firewall Anda jika Anda sangat paranoid, meskipun ini berarti Anda mungkin melewatkan pembaruan runtime dan model yang dapat mengoptimalkan performa. Dari analisis paket data, banyak pengguna merasa cukup puas dengan tingkat privasi yang ditawarkan.

Untuk memaksimalkan performa, tips penting adalah mengarahkan sebagian besar beban kerja ke GPU Anda. Idealnya, model yang Anda pilih harus muat sepenuhnya di VRAM GPU Anda untuk menghindari offloading ke CPU. Oleh karena itu, selalu maksimalkan pengaturan GPU offload kapan pun memungkinkan di LM Studio.

Alternatif Lain untuk Menjalankan LLM Lokal: Pilihan Sumber Terbuka

Jika Ollama atau LM Studio tidak sepenuhnya memenuhi kebutuhan Anda, atau jika Anda ingin menjelajahi opsi sumber terbuka lainnya untuk menjalankan LLM lokal, ada banyak alternatif yang tersedia. Beberapa di antaranya mungkin memerlukan sedikit lebih banyak upaya teknis, seperti membangun antarmuka melalui Docker atau memiliki prasyarat lain seperti Python atau Node.js. Namun, mereka menawarkan fleksibilitas dan kendali yang lebih besar bagi pengguna yang lebih maju atau mereka yang sangat memprioritaskan transparansi sumber terbuka.

OpenWebUI: Antarmuka Web untuk Llama.cpp dan Ollama

OpenWebUI adalah antarmuka web yang sangat populer dan sepenuhnya sumber terbuka yang dapat diintegrasikan dengan baik dengan llama.cpp atau Ollama. Ini menyediakan pengalaman seperti ChatGPT yang dapat diakses melalui browser web Anda, menjadikannya ideal untuk penggunaan pribadi atau bahkan diatur sebagai server AI di jaringan lokal. Instalasi biasanya melibatkan Docker, yang memudahkan penyebaran dan manajemen. Anda bisa menemukan panduan memulai cepatnya untuk llama.cpp atau Ollama. Ini adalah pilihan yang sangat baik jika Anda menginginkan antarmuka web yang fleksibel dan dapat diakses dari mana saja di jaringan Anda.

Pilihan Lain yang Kuat

Komunitas sumber terbuka terus berinovasi, dan ada beberapa proyek lain yang patut dipertimbangkan:

- GPT4ALL (github.com/nomic-ai/gpt4all): Dengan lebih dari 76 ribu bintang di GitHub, GPT4ALL adalah ekosistem yang menyediakan model dan aplikasi desktop untuk menjalankan LLM secara lokal. Aplikasi ini dirancang agar mudah digunakan dan mendukung berbagai model.

- AnythingLLM (github.com/Mintplex-Labs/anything-llm): Proyek dengan hampir 50 ribu bintang ini berfokus pada kemampuan LLM untuk berinteraksi dengan data Anda sendiri (RAG – Retrieval Augmented Generation). Ini memungkinkan Anda mengunggah dokumen dan berbicara dengan mereka menggunakan model LLM lokal Anda.

- LocalAI (github.com/mudler/LocalAI): Dengan lebih dari 35 ribu bintang, LocalAI adalah proyek yang membawa kemampuan AI generatif ke lingkungan lokal Anda dengan API yang kompatibel dengan OpenAI. Ini mendukung berbagai jenis model, termasuk LLM, model visual, dan model audio.

- Koboldcpp (github.com/LostRuins/koboldcpp): Sebuah implementasi

llama.cppyang berfokus pada penggunaan dengan model yang berorientasi cerita dan naratif, sangat populer di kalangan penulis dan pengembang game.

Setiap alternatif ini menawarkan keunikan dan keunggulannya sendiri, memungkinkan Anda untuk menyesuaikan pengalaman menjalankan LLM lokal sesuai dengan kebutuhan dan preferensi teknis Anda.

Memilih Model LLM yang Tepat: Panduan dari GPT-oss hingga Gemma

Salah satu keputusan paling penting saat menjalankan LLM lokal adalah memilih model yang tepat. Dengan begitu banyak model yang tersedia, proses ini bisa terasa sedikit membingungkan. Cara termudah untuk memulainya adalah dengan mengunduh model yang terlihat kompatibel dengan spesifikasi hardware Anda. Alat seperti LM Studio secara default akan menampilkan versi 4-bit kuantisasi dari model yang kemungkinan besar dapat dijalankan oleh mesin Anda. Pilihlah salah satu dari mereka, dan Anda kemungkinan besar akan mendapatkan kinerja yang mirip dengan model aslinya, tetapi dengan hardware konsumen.

Model Rekomendasi Umum

Ada beberapa model yang secara konsisten mendapatkan pujian karena keseimbangan antara kinerja dan kemampuan untuk dijalankan secara lokal:

- GPT-oss (dari OpenAI): Versi sumber terbuka yang dirilis oleh OpenAI, menawarkan kinerja yang solid untuk berbagai tugas.

- Gemma (oleh Google): Model ringan dan canggih dari Google yang dirancang untuk mendukung inovasi di komunitas pengembang.

- Qwen (oleh Alibaba Cloud): Seri model yang kuat dari Alibaba Cloud, dikenal karena performa multilingua yang baik.

- Distilled models (dari DeepSeek): Model yang lebih kecil namun dioptimalkan dari model yang lebih besar, menawarkan efisiensi tanpa mengorbankan terlalu banyak kualitas.

- Mistral (dari Mistral AI): Terkenal karena efisiensi dan kemampuannya, dengan varian seperti Mistral Small yang cocok untuk hardware yang lebih sederhana.

- Phi (oleh Microsoft): Seri model kecil namun sangat cerdas dari Microsoft, seringkali mengejutkan dengan kemampuannya meskipun ukurannya ringkas.

Selain model serbaguna, ada juga model yang dirancang khusus untuk tugas tertentu:

- Qwen-Coder, Devstral: Model yang dioptimalkan untuk tugas-tugas pengkodean.

- Mathstral: Dirancang untuk tugas-tugas yang berkaitan dengan matematika dan STEM.

Jika ada tugas tertentu dalam pikiran Anda (pencarian, penelitian, OCR, pemrosesan gambar, dll.), kemungkinan besar sudah ada model spesifik yang dirancang untuk itu. Bagi Anda yang tidak memiliki GPU, jangan khawatir! Ada banyak model yang lebih kecil yang dapat Anda coba, seperti Gemma 3-1b, Gemma 3-4b, TinyLLama, atau Mistral 7b. Model-model ini dirancang untuk lebih hemat sumber daya dan dapat memberikan pengalaman yang mengejutkan pada CPU saja.

HuggingFace adalah sumber daya yang luar biasa untuk menemukan model. Situs ini bahkan memiliki opsi untuk menambahkan detail hardware Anda dan akan menyoroti semua kuantisasi model yang kemungkinan dapat Anda jalankan. Tujuan Anda adalah memilih model yang dapat dijalankan dengan nyaman oleh mesin Anda dalam kuantisasi “Q4_K_M”. Kuantisasi ini menawarkan keseimbangan terbaik antara kualitas, kecepatan, dan ukuran file. Jika Anda ingin memahami lebih lanjut tentang arti di balik penamaan kuantisasi ini, artikel ini (Demystifying LLM Quantization Suffixes) dapat memberikan penjelasan mendalam. Selalu ingat, model terbaik adalah yang dapat Anda jalankan dengan lancar dan yang paling sesuai dengan kebutuhan spesifik Anda.

Optimalisasi Performa LLM Lokal: Tips dan Trik Tingkat Lanjut

Setelah Anda berhasil menjalankan LLM lokal, langkah selanjutnya adalah memastikan Anda mendapatkan performa terbaik dari setup Anda. Ada beberapa strategi dan trik yang dapat Anda terapkan untuk mengoptimalkan kecepatan inferensi, efisiensi sumber daya, dan kualitas output dari model-model Anda.

Memaksimalkan Penggunaan GPU

Seperti yang telah dibahas sebelumnya, GPU adalah kunci untuk kecepatan inferensi yang optimal. Pastikan sebanyak mungkin parameter model di-offload ke VRAM GPU Anda. Di aplikasi seperti LM Studio, ada pengaturan “GPU offload” atau “layers to GPU” yang memungkinkan Anda menentukan berapa banyak lapisan model yang akan diproses oleh GPU. Selalu usahakan untuk memaksimalkan pengaturan ini hingga model sepenuhnya muat di VRAM GPU Anda. Jika model terlalu besar untuk VRAM Anda, sistem akan secara otomatis membagi beban antara GPU dan RAM sistem, yang dikenal sebagai “offloading”, tetapi ini akan jauh lebih lambat daripada sepenuhnya di GPU.

Pemilihan Kuantisasi yang Cerdas

Kuantisasi 4-bit (terutama varian Q4_K_M) adalah titik awal yang bagus. Namun, jika Anda memiliki GPU dengan VRAM yang lebih besar (misalnya 12GB atau lebih), Anda mungkin bisa mencoba kuantisasi 5-bit atau bahkan 6-bit untuk model yang lebih kecil. Kuantisasi dengan bit yang lebih tinggi akan menghasilkan output yang sedikit lebih berkualitas dengan sedikit peningkatan ukuran file dan penggunaan VRAM. Lakukan eksperimen dengan beberapa kuantisasi berbeda dari model yang sama untuk menemukan sweet spot antara kualitas dan kecepatan yang paling sesuai untuk hardware Anda. Ingat, meskipun model “suck at answering things they don’t have the data for”, menjalankan model dengan parameter tertinggi yang bisa ditangani oleh sistem Anda akan memberikan hasil terbaik secara keseluruhan.

Manajemen Sumber Daya Sistem

- Tutup Aplikasi yang Tidak Perlu: Sebelum menjalankan LLM, tutup aplikasi latar belakang yang memakan RAM atau VRAM secara signifikan. Ini akan membebaskan sumber daya berharga untuk LLM Anda.

- Prioritas Proses: Di beberapa sistem operasi, Anda dapat mengatur prioritas proses untuk aplikasi LLM. Memberikannya prioritas yang lebih tinggi dapat membantu memastikan LLM mendapatkan jatah CPU dan memori yang lebih besar saat dibutuhkan.

- Perbarui Driver GPU: Pastikan driver GPU Anda selalu terbaru. Pembaruan driver seringkali mencakup optimisasi kinerja dan perbaikan bug yang dapat secara signifikan meningkatkan performa AI.

Optimalisasi ini akan membantu Anda mendapatkan pengalaman terbaik saat menjalankan LLM lokal, memastikan AI Anda beroperasi secepat dan seefisien mungkin.

Kasus Penggunaan dan Potensi LLM Lokal: Lebih dari Sekadar Chatbot

Potensi untuk menjalankan LLM lokal melampaui sekadar memiliki chatbot pribadi. Dengan privasi yang terjamin dan kendali penuh, LLM lokal dapat diintegrasikan ke dalam berbagai alur kerja dan kasus penggunaan yang kreatif dan produktif. Ini membuka pintu bagi inovasi yang mungkin terbatas oleh batasan layanan cloud atau biaya API.

Asisten Penulisan dan Kreatif

Bayangkan memiliki asisten penulisan yang selalu tersedia, memahami gaya Anda, dan tidak pernah mengirim data Anda ke luar. LLM lokal dapat membantu dalam penulisan email, artikel, naskah, atau bahkan konten kreatif seperti puisi dan cerita. Dengan fine-tuning, model dapat disesuaikan untuk menghasilkan konten dalam nada dan gaya tertentu yang sangat personal.

Pengembangan Perangkat Lunak

Pengembang dapat memanfaatkan LLM lokal untuk berbagai tugas, seperti:

- Pembuatan Kode Otomatis: Minta model untuk menghasilkan cuplikan kode, fungsi, atau bahkan seluruh file berdasarkan deskripsi Anda.

- Refactoring dan Debugging: Model dapat membantu mengidentifikasi potensi masalah dalam kode Anda atau menyarankan cara untuk meningkatkan efisiensi.

- Dokumentasi Kode: Otomatiskan pembuatan dokumentasi untuk fungsi atau kelas yang Anda tulis.

Kemampuan ini sangat berguna, terutama ketika bekerja dengan proyek-proyek rahasia perusahaan yang tidak boleh memiliki kode yang diunggah ke server eksternal. Untuk pemahaman lebih lanjut tentang bagaimana sistem AI skala besar dibangun, Anda dapat melihat artikel kami tentang Membangun Sistem AI Skala Besar.

Penelitian dan Analisis Data

Peneliti dan analis dapat menggunakan LLM lokal untuk meringkas dokumen panjang, mengekstrak informasi penting dari laporan, atau bahkan membantu dalam analisis data kualitatif. Data sensitif dalam penelitian, seperti catatan pasien atau hasil studi rahasia, dapat diproses dengan aman di lingkungan lokal. Jika Anda tertarik dengan AI generatif dan dampaknya, mungkin Anda juga ingin membaca tentang Sora AI – Revolusi Video Generatif.

Penggunaan Edukasi dan Pribadi

Sebagai alat pembelajaran, LLM lokal bisa menjadi tutor pribadi yang interaktif, membantu menjelaskan konsep-konsep kompleks dalam berbagai mata pelajaran. Secara pribadi, Anda bisa menggunakannya sebagai teman curhat digital, alat perencanaan, atau bahkan untuk eksperimen bahasa dan kreativitas tanpa khawatir tentang batasan penggunaan atau sensor.

Dengan terus berkembangnya model dan alat untuk menjalankan LLM lokal, daftar kasus penggunaan ini akan terus bertambah, menjadikan AI yang kuat ini semakin personal dan terintegrasi dalam kehidupan kita.

Tantangan dan Pertimbangan dalam Menjalankan LLM Lokal

Meskipun menjalankan LLM lokal menawarkan banyak keuntungan, penting untuk juga menyadari tantangan dan pertimbangan yang mungkin muncul. Seperti halnya teknologi canggih lainnya, ada kurva pembelajaran dan batasan tertentu yang perlu diantisipasi oleh pengguna.

Keterbatasan Hardware

Seperti yang telah dibahas, hardware adalah faktor pembatas utama. Tidak semua model LLM dapat berjalan secara efektif pada setiap konfigurasi komputer. Meskipun ada model yang dioptimalkan untuk CPU atau GPU dengan VRAM terbatas, model-model “frontier” terbaru dengan miliaran parameter dan kinerja terbaik masih membutuhkan spesifikasi hardware kelas atas. Ini berarti bahwa untuk sebagian besar pengguna konsumen, akan ada kompromi antara ukuran model (dan dengan demikian, kapabilitas) dan performa. Jika Anda memiliki hardware yang lebih tua atau lebih lemah, Anda mungkin harus puas dengan model yang lebih kecil yang mungkin tidak sekompeten model online terbaik.

Kurva Pembelajaran dan Penyiapan Awal

Meskipun alat seperti Ollama dan LM Studio telah menyederhanakan proses instalasi, masih ada kurva pembelajaran. Pengguna perlu memahami konsep-konsep seperti kuantisasi, pemilihan model, dan pengaturan optimalisasi hardware. Bagi mereka yang kurang familiar dengan istilah teknis atau manajemen file, proses penyiapan awal bisa terasa sedikit menakutkan. Mengidentifikasi driver GPU yang benar, memantau penggunaan VRAM, dan menyesuaikan pengaturan offload membutuhkan sedikit riset dan eksperimen. Jika Anda tertarik pada komputasi AI kelas data center, Anda bisa mencari informasi tentang Nvidia DGX Spark.

Pembaruan dan Pemeliharaan

Ekosistem LLM berkembang pesat. Model baru, versi kuantisasi yang lebih efisien, dan pembaruan pada alat inferensi dirilis secara teratur. Ini berarti Anda perlu meluangkan waktu untuk memperbarui model dan perangkat lunak Anda secara berkala agar tetap mendapatkan fitur dan optimisasi terbaru. Meskipun ini memastikan Anda selalu menggunakan teknologi tercanggih, ini juga merupakan komitmen waktu yang berkelanjutan.

Ketersediaan Model dan Lisensi

Meskipun banyak model bersifat “open-weight”, penting untuk memeriksa lisensi masing-masing model. Beberapa model mungkin memiliki batasan penggunaan komersial, atau memerlukan atribusi. Selain itu, tidak semua model yang tersedia secara online mudah diadaptasi atau dikuantisasi untuk dijalankan secara lokal. Terkadang, Anda mungkin harus menunggu komunitas untuk merilis versi yang kompatibel.

Mempertimbangkan tantangan ini akan membantu Anda menyiapkan ekspektasi yang realistis dan memaksimalkan potensi menjalankan LLM lokal di lingkungan Anda.

Pertanyaan yang Sering Diajukan (FAQ)

Menjalankan LLM lokal menawarkan privasi data yang mutlak karena semua pemrosesan terjadi di perangkat Anda, tanpa mengirim data ke server pihak ketiga. Selain itu, Anda mendapatkan kendali penuh atas model, dapat beroperasi secara offline, berpotensi lebih cepat tergantung hardware, dan tidak memerlukan biaya langganan bulanan. Ini juga memungkinkan integrasi API lokal yang lebih fleksibel dan potensi untuk fine-tuning model sesuai kebutuhan spesifik Anda.

Persyaratan utama meliputi RAM yang cukup (ukuran model harus lebih kecil dari RAM Anda), GPU khusus sangat direkomendasikan (terutama Nvidia RTX atau Apple M-chipset) untuk kecepatan inferensi, dan CPU modern untuk pemrosesan prompt. Pastikan juga Anda memiliki ruang penyimpanan yang memadai untuk file model yang besar, dan SSD akan mempercepat pemuatan. Alat seperti LM Studio biasanya akan memberikan rekomendasi model berdasarkan spesifikasi hardware Anda.

Ollama adalah pilihan terbaik untuk pemula karena kesederhanaan dan antarmuka yang bersih, memungkinkan Anda memulai dengan cepat. LM Studio menawarkan antarmuka yang lebih kaya fitur, kontrol yang lebih mendalam, dan seringkali kecepatan inferensi yang lebih tinggi. Keduanya mudah diinstal dan memungkinkan Anda mengunduh model dengan cepat. Ollama bersifat open-source, sementara LM Studio closed-source tetapi transparan tentang data yang dikumpulkan.

Kesimpulan

Memulai perjalanan menjalankan LLM lokal adalah langkah yang memberdayakan, menawarkan kendali penuh, privasi tak tertandingi, dan potensi performa yang menyaingi solusi berbasis cloud. Kita telah menjelajahi berbagai alasan kuat untuk mengadopsi pendekatan ini, mulai dari keamanan data absolut hingga fleksibilitas operasional yang tidak memerlukan koneksi internet. Pemahaman akan persyaratan hardware, seperti peran vital RAM dan GPU, serta konsep teknis seperti kuantisasi dan proyek llama.cpp, akan membekali Anda dengan pengetahuan untuk membuat keputusan yang tepat.

Dengan alat seperti Ollama yang menawarkan kesederhanaan “klik dan jalankan”, serta LM Studio yang menyajikan antarmuka kaya fitur dengan opsi optimisasi mendalam, pintu menuju AI pribadi Anda terbuka lebar. Tidak peduli apakah Anda seorang pengembang, peneliti, atau hanya seorang penggemar teknologi, LLM lokal menawarkan medan bermain yang luas untuk eksplorasi dan inovasi. Jadi, tunggu apa lagi? Ambil kendali penuh atas pengalaman AI Anda, eksperimen dengan berbagai model dan konfigurasi, dan rasakan kekuatan kecerdasan buatan yang benar-benar ada di tangan Anda.